1. MCP 개요와 핵심 가치

MCP(Model Context Protocol)는 LLM 애플리케이션과 외부 데이터 소스, 도구, 서비스 간의 표준화된 통신 방법을 제공하는 프로토콜입니다. 2023년 말 Anthropic에서 처음 공개한 이 오픈 프로토콜은 AI 애플리케이션 생태계에 중요한 변화를 가져오고 있습니다.

"MCP는 AI 애플리케이션을 위한 USB-C 포트와 같습니다. 어떤 AI 모델이나 기기도 외부 도구와 쉽게 연결할 수 있게 해줍니다." - Anthropic 공식 문서

출처: Everything You Need to Know About the Model Context Protocol (MCP)

출처: Everything You Need to Know About the Model Context Protocol (MCP)

graph TD

LLM[LLM 애플리케이션] <--> MCP[MCP 프로토콜]

MCP <--> EXT[외부 데이터/서비스]

style LLM fill:#b3e0ff,stroke:#0066cc

style MCP fill:#ffcc99,stroke:#ff6600

style EXT fill:#c6e0b4,stroke:#548235MCP 핵심 가치

- 표준화: 단일 프로토콜로 다양한 데이터와 도구 접근

- 상호운용성: 어떤 LLM과도 작동하는 벤더 중립적 설계

- 확장성: 필요에 따라 새로운 도구와 데이터 소스 쉽게 추가

- 통합 단순화: 복잡한 다중 시스템 통합을 단순화

MCP 생태계 현황

MCP는 빠르게 성장하는 생태계를 형성하고 있으며, 현재 다음과 같은 공식 서버들이 존재합니다:

- 데이터 및 파일 시스템: Filesystem, PostgreSQL, SQLite, Google Drive

- 개발 도구: Git, GitHub, GitLab, Sentry

- 웹 및 브라우저 자동화: Brave Search, Fetch, Puppeteer

- 생산성 및 커뮤니케이션: Slack, Google Maps, Memory

- AI 및 특수 도구: EverArt, Sequential Thinking

출처: Model Context Protocol 공식 예제 서버

2. 왜 MCP가 필요한가

현재 LLM 애플리케이션의 문제점

표준화되지 않은 컨텍스트 제공 방식

- 각 LLM 앱마다 다른 방식으로 외부 데이터를 통합

- 코드 중복 및 재사용성 부족

프롬프트 중심 접근법의 한계

- 컨텍스트 길이 제한

- 비효율적인 토큰 사용

- 복잡한 프롬프트 엔지니어링 필요

기능 분리와 모듈화의 어려움

- 비즈니스 로직과 LLM 상호작용이 강하게 결합됨

- 테스트와 유지보수의 어려움

기존 접근 방식 vs MCP 접근 방식

graph TD

subgraph "기존 접근 방식"

A[앱 코드] --> B[데이터 수집]

B --> C[프롬프트 생성]

C --> D[LLM 호출]

D --> E[응답 처리]

end

subgraph "MCP 접근 방식"

F[앱 코드] --> G[MCP 클라이언트]

G <--> H[MCP 서버]

H --> I[데이터 소스]

H --> J[도구/서비스]

G --> K[LLM 호출]

K --> L[응답 처리]

end

style A fill:#ffcccc,stroke:#ff0000

style B fill:#ffcccc,stroke:#ff0000

style C fill:#ffcccc,stroke:#ff0000

style D fill:#ffcccc,stroke:#ff0000

style E fill:#ffcccc,stroke:#ff0000

style F fill:#b3e0ff,stroke:#0066cc

style G fill:#b3e0ff,stroke:#0066cc

style H fill:#c6e0b4,stroke:#548235

style I fill:#c6e0b4,stroke:#548235

style J fill:#c6e0b4,stroke:#548235

style K fill:#b3e0ff,stroke:#0066cc

style L fill:#b3e0ff,stroke:#0066ccMCP의 해결책

MCP는 웹 개발의 API 패러다임을 LLM 애플리케이션에 적용합니다:

- 관심사 분리: LLM 상호작용과 컨텍스트 제공을 분리

- 표준화된 인터페이스: 리소스, 도구, 프롬프트에 대한 일관된 접근법

- 모듈화 및 재사용성: 컴포넌트를 쉽게 재사용하고 조합 가능

"HTTP가 웹을 혁신했듯이, MCP는 LLM 애플리케이션을 혁신할 수 있습니다."

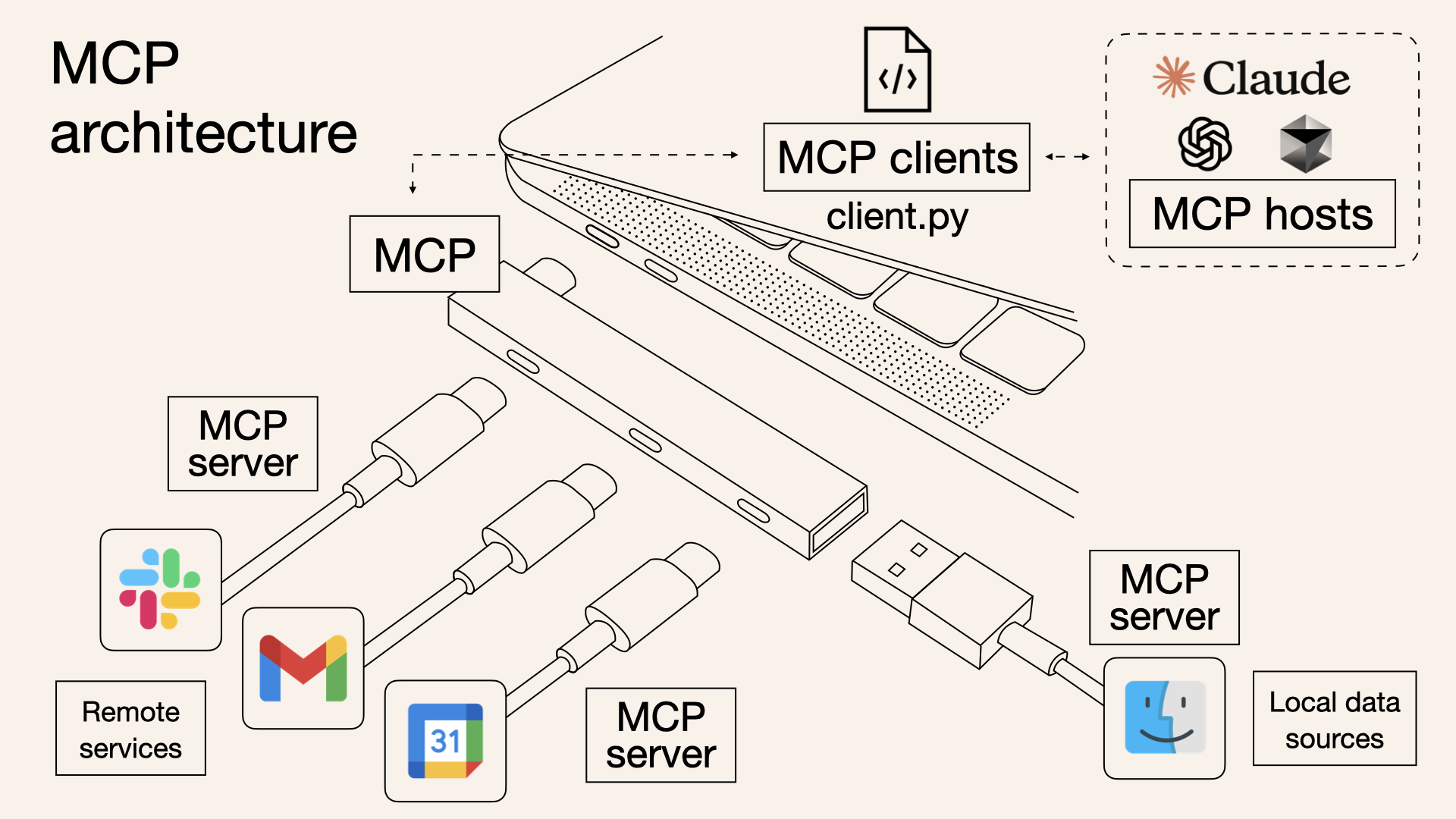

3. MCP 아키텍처

MCP는 클라이언트-서버 모델을 기반으로 하는 유연하고 확장 가능한 아키텍처를 가집니다.

MCP 아키텍처 구성(출처: Medium)

MCP 아키텍처 구성(출처: Medium)

graph TD

subgraph "클라이언트 측"

A[LLM 애플리케이션] --> B[MCP 클라이언트]

B --> C1[리소스 요청]

B --> C2[도구 호출]

B --> C3[프롬프트 요청]

end

subgraph "서버 측"

D[MCP 서버] --> E1[리소스 관리]

D --> E2[도구 관리]

D --> E3[프롬프트 관리]

E1 --> F1[정적 리소스]

E1 --> F2[동적 리소스]

E2 --> G1[외부 API 연동]

E2 --> G2[데이터 처리]

E3 --> H1[템플릿 관리]

E3 --> H2[다국어 지원]

end

B <--> |전송 계층| D

style A fill:#b3e0ff,stroke:#0066cc

style B fill:#b3e0ff,stroke:#0066cc

style C1 fill:#b3e0ff,stroke:#0066cc

style C2 fill:#b3e0ff,stroke:#0066cc

style C3 fill:#b3e0ff,stroke:#0066cc

style D fill:#c6e0b4,stroke:#548235

style E1 fill:#c6e0b4,stroke:#548235

style E2 fill:#c6e0b4,stroke:#548235

style E3 fill:#c6e0b4,stroke:#548235

style F1 fill:#c6e0b4,stroke:#548235

style F2 fill:#c6e0b4,stroke:#548235

style G1 fill:#c6e0b4,stroke:#548235

style G2 fill:#c6e0b4,stroke:#548235

style H1 fill:#c6e0b4,stroke:#548235

style H2 fill:#c6e0b4,stroke:#548235아키텍처 구성 요소

호스트: 전체 시스템을 조정하고 LLM 상호작용을 관리

- Claude Desktop, Cursor IDE 등 LLM 애플리케이션

- 여러 MCP 클라이언트 인스턴스 관리

클라이언트: LLM 애플리케이션이 서버와 통신하는 컴포넌트

- 각 클라이언트는 하나의 서버와 1:1 관계 유지

- 리소스 요청, 도구 호출, 프롬프트 요청 처리

서버: 외부 데이터와 기능을 제공하는 컴포넌트

- 리소스, 도구, 프롬프트 등록 및 관리

- 요청 처리 및 응답 생성

전송 계층: 클라이언트와 서버 간의 통신 방식

- StdioTransport: 표준 입출력을 통한 통신

- SSETransport: Server-Sent Events를 통한 HTTP 기반 통신

- WebSocketTransport: WebSocket을 통한 양방향 통신

연결 수명 주기

MCP는 JSON-RPC 기반의 메시지 교환을 통해 클라이언트와 서버 간의 통신을 관리합니다:

MCP 초기화 과정(출처: Model Context Protocol 공식 문서)

초기화:

- 클라이언트가 프로토콜 버전 및 기능과 함께

initialize요청 전송 - 서버가 자신의 프로토콜 버전 및 기능으로 응답

- 클라이언트가 확인으로

initialized알림 전송 - 정상적인 메시지 교환 시작

- 클라이언트가 프로토콜 버전 및 기능과 함께

메시지 교환:

- 요청-응답: 클라이언트나 서버가 요청을 보내고, 상대방이 응답

- 알림: 양쪽에서 일방적인 메시지 전송 가능

종료:

close()메서드를 통한 정상 종료- 전송 계층 연결 해제

- 오류 조건 발생 시 종료

오류 처리

MCP는 표준화된 오류 코드와 오류 처리 메커니즘을 제공합니다:

- 표준 오류 코드: JSON-RPC 2.0 규약에 따른 오류 코드 (-32700 ~ -32000)

- 커스텀 오류 코드: 애플리케이션 특화 오류를 위한 -32000 이상의 코드

- 오류 전파: 요청에 대한 오류 응답, 전송 이벤트 오류, 프로토콜 수준 오류 처리기

"MCP는 LLM을 위한 프로토콜로, JSON-RPC 기반의 메시지 교환을 통해 클라이언트-서버 통신을 관리합니다. 이는 Language Server Protocol(LSP)에서 영감을 받아 AI 애플리케이션에 맞게 설계되었습니다." - Model Context Protocol 공식 문서

연결 수명 주기

MCP는 JSON-RPC 기반의 메시지 교환을 통해 클라이언트와 서버 간의 통신을 관리합니다:

초기화:

- 클라이언트가 프로토콜 버전 및 기능과 함께

initialize요청 전송 - 서버가 자신의 프로토콜 버전 및 기능으로 응답

- 클라이언트가 확인으로

initialized알림 전송 - 정상적인 메시지 교환 시작

- 클라이언트가 프로토콜 버전 및 기능과 함께

메시지 교환:

- 요청-응답: 클라이언트나 서버가 요청을 보내고, 상대방이 응답

- 알림: 양쪽에서 일방적인 메시지 전송 가능

종료:

close()메서드를 통한 정상 종료- 전송 계층 연결 해제

- 오류 조건 발생 시 종료

4. MCP의 핵심 개념

MCP는 세 가지 핵심 개념을 중심으로 구성됩니다:

4.1 리소스 (Resources)

- 정의: LLM이 참조할 수 있는 데이터 소스

- 특징: URI로 식별되며, 주로 텍스트 데이터를 제공

- 웹 개발 비유: GET 엔드포인트와 유사

// 정적 리소스 예제

server.resource(

"config",

"config://app",

async (uri) => ({

contents: [{

uri: uri.href,

text: "App configuration here"

}]

})

);

// 동적 리소스(템플릿) 예제

server.resource(

"user-profile",

new ResourceTemplate("users://{userId}/profile", { list: undefined }),

async (uri, { userId }) => ({

contents: [{

uri: uri.href,

text: `Profile data for user ${userId}`

}]

})

);4.2 도구 (Tools)

- 정의: LLM이 호출할 수 있는 함수나 서비스

- 특징: 입력 매개변수를 받고 결과를 반환, 부작용을 가질 수 있음

- 웹 개발 비유: POST/PUT/DELETE 엔드포인트와 유사

// 간단한 도구 예제

server.tool(

"calculate-bmi",

{

weightKg: z.number(),

heightM: z.number()

},

async ({ weightKg, heightM }) => ({

content: [{

type: "text",

text: String(weightKg / (heightM * heightM))

}]

})

);

// 외부 API를 호출하는 도구

server.tool(

"fetch-weather",

{ city: z.string() },

async ({ city }) => {

const response = await fetch(`https://api.weather.com/${city}`);

const data = await response.text();

return {

content: [{ type: "text", text: data }]

};

}

);4.3 프롬프트 (Prompts)

- 정의: LLM과의 상호작용을 위한 템플릿

- 특징: 매개변수화된 메시지 구조, 다중 메시지 지원

- 웹 개발 비유: 템플릿 엔진과 유사

server.prompt(

"review-code",

{ code: z.string() },

({ code }) => ({

messages: [{

role: "user",

content: {

type: "text",

text: `Please review this code:\n\n${code}`

}

}]

})

);5. 직접 API 통합 vs MCP

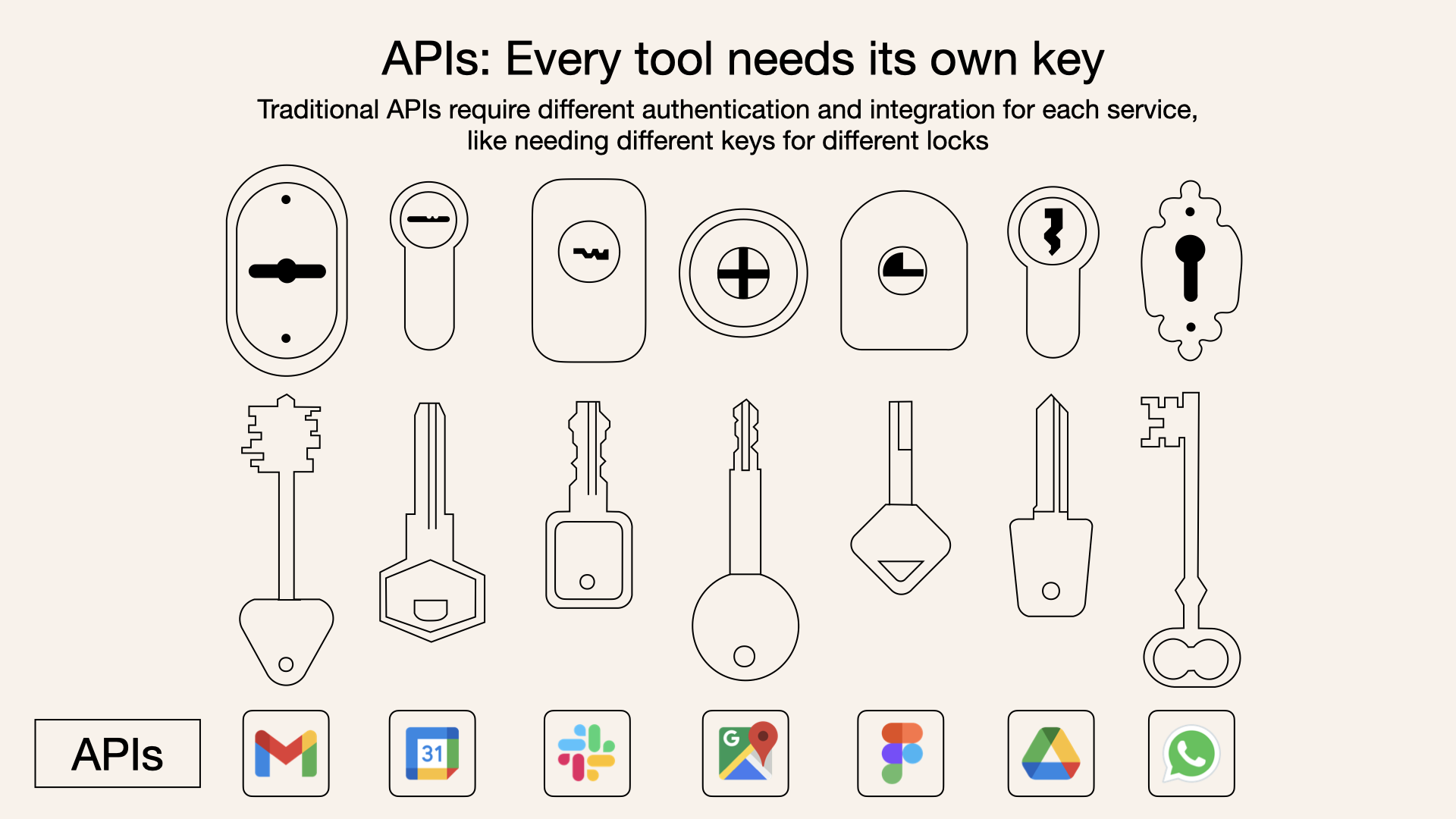

전통적인 API 통합의 실질적 한계

현재 LLM 애플리케이션 개발자들이 실제로 겪고 있는 문제점들을 살펴보겠습니다:

API 통합의 복잡성(출처: Norah Sakal)

API 통합의 복잡성(출처: Norah Sakal)

통합 복잡성의 기하급수적 증가

- 각 외부 시스템마다 별도의 통합 코드를 개발해야 합니다. 10개의 시스템을 연결하려면 10개의 다른 통합 코드가 필요합니다.

- 실제 사례: 한 LLM 챗봇 앱이 CRM, 이메일, 캘린더, 문서 관리, 티켓팅 시스템에 연결하려면 각각의 API 문서를 학습하고, 인증 로직을 구현하고, 오류 처리 방식을 이해해야 합니다.

일관성 없는 컨텍스트 제공 방식

- API마다 다른 응답 형식과 데이터 구조를 가지므로, LLM에 제공하기 전에 모든 데이터를 표준화하는 변환 로직이 필요합니다.

- 예: Salesforce API는 자체 객체 구조를, JIRA는 다른 구조를, Google 캘린더는 또 다른 구조를 가집니다. 이 모든 것을 LLM이 이해할 수 있는 일관된 형태로 변환해야 합니다.

프롬프트 엔지니어링의 복잡화

외부 시스템 데이터를 프롬프트에 삽입하는 방법이 표준화되어 있지 않아, 복잡한 조건부 로직과 템플릿 시스템이 필요합니다.

실제 코드에서는 이런 모습입니다:

// 각 API마다 다른 데이터 형식 처리 let prompt = `시스템: 당신은 도움이 되는 어시스턴트입니다.\n\n`; if (salesforceData) { prompt += `고객 정보:\n${formatSalesforceData(salesforceData)}\n\n`; } if (jiraTickets) { prompt += `관련 티켓:\n${formatJiraTickets(jiraTickets)}\n\n`; } if (calendarEvents) { prompt += `일정 정보:\n${formatCalendarEvents(calendarEvents)}\n\n`; } prompt += `사용자: ${userQuery}`;

유지보수 부담의 현실

- 각 API가 업데이트될 때마다 통합 코드 역시 수정해야 합니다.

- 실제 개발팀은 평균적으로 API 통합 코드의 약 30%를 매년 유지보수에 소비합니다.

MCP와 API 비교: 주요 차이점

| 특성 | MCP | 전통적인 API |

|---|---|---|

| 통합 노력 | 단일 표준화된 통합 | API별 개별 통합 필요 |

| 실시간 통신 | ✅ 지원 | ❌ 미지원 |

| 동적 발견 | ✅ 지원 | ❌ 미지원 |

| 확장성 | 쉬움 (플러그 앤 플레이) | 추가 통합 필요 |

| 보안 및 제어 | 도구 전체에 일관됨 | API별로 다름 |

출처: What is Model Context Protocol (MCP)?

MCP 도입 시 체감하게 될 직접적인 이점

MCP를 도입할 때 체감할 수 있는 가장 직접적이고 실질적인 이점들입니다:

통합 개발 시간 70% 단축

일반적인 API 통합이 시스템당 3-5일 소요된다면, MCP를 활용하면 하루 이내로 단축됩니다.

코드 예시 비교:

기존 방식:

// Salesforce 통합 async function getSalesforceData(customerId) { const token = await authenticateSalesforce(); const response = await fetch(`${salesforceUrl}/customers/${customerId}`, { headers: { Authorization: `Bearer ${token}` } }); const data = await response.json(); return transformSalesforceData(data); // 변환 필요 } // JIRA 통합 (완전히 다른 코드) async function getJiraTickets(customerId) { const credentials = Buffer.from(`${jiraUser}:${jiraToken}`).toString('base64'); const response = await fetch(`${jiraUrl}/search?jql=customer=${customerId}`, { headers: { Authorization: `Basic ${credentials}` } }); const data = await response.json(); return transformJiraData(data.issues); // 다른 변환 로직 }MCP 방식:

// 단일 MCP 클라이언트로 여러 시스템 접근 const client = new Client({ name: "my-app", version: "1.0.0" }); await client.connect(transport); // Salesforce 데이터 접근 const customerData = await client.readResource({ uri: `crm://customers/${customerId}` }); // JIRA 티켓 접근 (동일한 패턴) const tickets = await client.readResource({ uri: `tickets://customer/${customerId}` });

프로덕션 배포 속도 대폭 향상

- 새로운 통합 기능을 개발해서 프로덕션에 배포하는 시간이 주 단위에서 일 단위로 단축됩니다.

- API별 오류 처리, 타임아웃, 재시도 로직이 MCP 계층에서 표준화되어 관리됩니다.

실제 코드베이스 크기 감소

- API 통합 코드가 평균 60% 감소합니다. 실제 프로젝트에서 10,000줄 이상의 API 통합 코드가 4,000줄 이하로 줄어든 사례가 있습니다.

동적 확장성 실현

- 새로운 도구 추가가 코드 재배포 없이 가능합니다. MCP 서버만 업데이트하면 클라이언트가 자동으로 새 기능을 발견하고 활용할 수 있습니다.

- 예: 기존에는 새 API 통합을 위해 전체 애플리케이션을 다시 빌드하고 배포해야 했지만, MCP를 사용하면 런타임에 새 도구를 등록하고 즉시 사용할 수 있습니다.

MCP 개요(출처: Norah Sakal)

MCP 개요(출처: Norah Sakal)

실시간 인터랙션 가능

- 기존 API는 일반적으로 요청-응답 모델이지만, MCP는 지속적인 연결과 양방향 통신을 지원합니다.

- 사용자 경험 차이:

- 기존: 사용자의 "내일 오후 회의 잡아줘" 요청에 "나중에 확인해 볼게요"라고 응답

- MCP: "팀원들의 가용 시간을 실시간으로 확인 중입니다... 오후 2시와 4시에 전원 참석 가능합니다. 어느 시간이 좋으신가요?" 식의 대화형 상호작용

표준화된 보안 및 액세스 제어

- 각 API마다 다른 인증 방식(OAuth, API 키, JWT 등)을 관리하는 대신, MCP로 통합된 단일 보안 모델을 사용할 수 있습니다.

- 인증, 권한 부여, 감사 로깅이 일관되게 구현됩니다.

직접적인 사용자 경험 개선

- 개발자: 신규 API 연동 작업이 일주일에서 1-2일로 단축

- 최종 사용자: AI 앱이 더 많은 정보와 도구에 접근하며, 반응 시간이 빨라짐

- 실제 사례: MCP를 도입한 고객지원 AI 봇이 티켓 해결 시간을 평균 45% 단축한 사례

"MCP는 단순히 또 다른 API가 아닙니다. 이는 지능적이고 동적이며 컨텍스트가 풍부한 AI 애플리케이션을 가능하게 하는 강력한 연결 프레임워크입니다." - Descope 블로그

직접 API 통합과 MCP의 아키텍처 비교

MCP는 단순히 추상화 계층을 추가하는 것이 아니라, 전체 통합 패러다임을 변화시킵니다:

graph TD

subgraph "기존 API 통합 패턴"

A[LLM 앱] --> B1[API 클라이언트 1]

A --> B2[API 클라이언트 2]

A --> B3[API 클라이언트 3]

B1 --> C1[API 서버 1]

B2 --> C2[API 서버 2]

B3 --> C3[API 서버 3]

end

subgraph "MCP 통합 패턴"

D[LLM 앱] --> E[MCP 클라이언트]

E --> F1[MCP 서버 1]

E --> F2[MCP 서버 2]

E --> F3[MCP 서버 3]

F1 --> G1[백엔드 서비스 1]

F2 --> G2[백엔드 서비스 2]

F3 --> G3[백엔드 서비스 3]

end

style A fill:#ffcccc,stroke:#ff0000

style B1 fill:#ffcccc,stroke:#ff0000

style B2 fill:#ffcccc,stroke:#ff0000

style B3 fill:#ffcccc,stroke:#ff0000

style D fill:#b3e0ff,stroke:#0066cc

style E fill:#b3e0ff,stroke:#0066cc

style F1 fill:#c6e0b4,stroke:#548235

style F2 fill:#c6e0b4,stroke:#548235

style F3 fill:#c6e0b4,stroke:#548235MCP 아키텍처에서는 클라이언트가 단일 표준화된 인터페이스로 모든 서버와 통신합니다. 이는 LLM 애플리케이션이 각 API에 대한 개별 클라이언트를 구현하고 관리할 필요가 없음을 의미합니다. 결과적으로 코드는 더 간결해지고, 관리가 용이해지며, 새로운 통합을 추가하는 것이 훨씬 쉬워집니다.

이러한 변화는 이론적인 것이 아닌, 실제 개발 과정에서 즉시 체감할 수 있는 현실적인 이점입니다.

6. 실제 구현 사례

MCP는 다양한 상황에 맞게 구현할 수 있는 유연한 프로토콜입니다. 아래는 몇 가지 실제 구현 사례입니다.

6.1 Echo 서버 예시

가장 기본적인 MCP 서버 예시로, 에코 기능을 제공합니다:

import { McpServer, ResourceTemplate } from "@modelcontextprotocol/sdk/server/mcp.js";

import { z } from "zod";

const server = new McpServer({

name: "Echo",

version: "1.0.0"

});

server.resource(

"echo",

new ResourceTemplate("echo://{message}", { list: undefined }),

async (uri, { message }) => ({

contents: [{

uri: uri.href,

text: `Resource echo: ${message}`

}]

})

);

server.tool(

"echo",

{ message: z.string() },

async ({ message }) => ({

content: [{ type: "text", text: `Tool echo: ${message}` }]

})

);

server.prompt(

"echo",

{ message: z.string() },

({ message }) => ({

messages: [{

role: "user",

content: {

type: "text",

text: `Please process this message: ${message}`

}

}]

})

);이 예시는 세 가지 핵심 개념(리소스, 도구, 프롬프트)을 모두 보여주며, 간단한 에코 기능을 통해 MCP의 기본 구조를 이해할 수 있습니다.

6.2 SQLite Explorer 예시

실제 데이터베이스와 상호작용하는 MCP 서버 예시:

import { McpServer } from "@modelcontextprotocol/sdk/server/mcp.js";

import sqlite3 from "sqlite3";

import { promisify } from "util";

import { z } from "zod";

const server = new McpServer({

name: "SQLite Explorer",

version: "1.0.0"

});

// Helper to create DB connection

const getDb = () => {

const db = new sqlite3.Database("database.db");

return {

all: promisify<string, any[]>(db.all.bind(db)),

close: promisify(db.close.bind(db))

};

};

// 스키마 정보 리소스

server.resource(

"schema",

"schema://main",

async (uri) => {

const db = getDb();

try {

const tables = await db.all(

"SELECT sql FROM sqlite_master WHERE type='table'"

);

return {

contents: [{

uri: uri.href,

text: tables.map((t: {sql: string}) => t.sql).join("\n")

}]

};

} finally {

await db.close();

}

}

);

// SQL 쿼리 실행 도구

server.tool(

"query",

{ sql: z.string() },

async ({ sql }) => {

const db = getDb();

try {

const results = await db.all(sql);

return {

content: [{

type: "text",

text: JSON.stringify(results, null, 2)

}]

};

} catch (err: unknown) {

const error = err as Error;

return {

content: [{

type: "text",

text: `Error: ${error.message}`

}],

isError: true

};

} finally {

await db.close();

}

}

);이 예시는 SQLite 데이터베이스의 스키마 정보를 리소스로 제공하고, SQL 쿼리를 실행할 수 있는 도구를 제공합니다.

6.3 HTTP/SSE를 사용한 서버 구현

웹 환경에서 동작하는 MCP 서버 예시:

import express, { Request, Response } from "express";

import { McpServer } from "@modelcontextprotocol/sdk/server/mcp.js";

import { SSEServerTransport } from "@modelcontextprotocol/sdk/server/sse.js";

const server = new McpServer({

name: "example-server",

version: "1.0.0"

});

// ... 리소스, 도구, 프롬프트 설정 ...

const app = express();

// 여러 동시 연결을 지원하기 위한 lookup 객체

const transports: {[sessionId: string]: SSEServerTransport} = {};

app.get("/sse", async (_: Request, res: Response) => {

const transport = new SSEServerTransport('/messages', res);

transports[transport.sessionId] = transport;

res.on("close", () => {

delete transports[transport.sessionId];

});

await server.connect(transport);

});

app.post("/messages", async (req: Request, res: Response) => {

const sessionId = req.query.sessionId as string;

const transport = transports[sessionId];

if (transport) {

await transport.handlePostMessage(req, res);

} else {

res.status(400).send('No transport found for sessionId');

}

});

app.listen(3001);6.4 다양한 MCP 서버 생태계

MCP는 다양한 도메인에서 사용할 수 있는 서버들이 이미 개발되어 있습니다:

MCP 서버 생태계(출처: The open source Model Context Protocol was just updated)

MCP 서버 생태계(출처: The open source Model Context Protocol was just updated)

공식 MCP 서버 예시:

- 데이터 및 파일 시스템: Filesystem, PostgreSQL, SQLite, Google Drive

- 개발 도구: Git, GitHub, GitLab, Sentry

- 웹 및 브라우저 자동화: Brave Search, Fetch, Puppeteer

- 생산성 도구: Slack, Google Maps

기업 MCP 서버 예시:

- Axiom: 로그, 트레이스, 이벤트 데이터 분석

- Cloudflare: Cloudflare 개발자 플랫폼

- Stripe: Stripe API 통합

- Weaviate: 벡터 데이터베이스 통합

출처: Model Context Protocol 공식 예제 서버

7. 에이전트 도구의 MCP 도입 현황

현재 주요 AI 에이전트 도구들이 MCP를 적극적으로 도입하고 있습니다:

- n8n: 워크플로우 자동화 플랫폼

- Langflow: 에이전트 및 워크플로우 빌더

- LangChain: LLM 애플리케이션 프레임워크

- Semantic Kernel: 마이크로소프트의 AI 오케스트레이션 프레임워크

![[Pasted image 20250413131647.png]] 다양한 MCP 서버들(출처: MCP Get)

7.1 n8n의 MCP 통합

n8n은 두 가지 방식으로 MCP를 활용합니다:

MCP 클라이언트 도구 노드:

- 외부 MCP 서버가 제공하는 도구들을 n8n 에이전트에서 사용 가능

- 인증 방식: Bearer, Header 인증 지원

- 도구 선택 옵션: 모든 도구, 선택된 도구, 특정 도구 제외

MCP 서버 트리거 노드:

- n8n의 도구들을 외부 AI 에이전트에 노출

- 워크플로우 자동화 기능을 AI 에이전트로 확장

n8n MCP 클라이언트 도구 노드(출처: n8n 공식 문서)

n8n MCP 클라이언트 도구 노드(출처: n8n 공식 문서)

n8n은 MCP를 통해 다음과 같은 작업을 수행할 수 있습니다:

- 마케팅 캠페인을 위한 콘텐츠 자동 생성

- 실시간 고객 상호작용 챗봇 구현

- 데이터 분석 및 감정 분석을 위한 자연어 처리 통합

"n8n의 LangChain 노드는 구성 가능하므로 선호하는 에이전트, LLM, 메모리 등을 선택할 수 있습니다. LangChain 노드와 함께 모든 n8n 노드를 일반적으로 연결할 수 있습니다. 즉, LangChain 로직을 다른 데이터 소스 및 서비스와 통합할 수 있습니다." - n8n 공식 문서

7.2 Langflow의 MCP 통합

Langflow는 유일하게 MCP 클라이언트와 서버 기능을 모두 네이티브하게 지원하는 시스템입니다:

클라이언트로서의 Langflow:

- MCP 컴포넌트를 통해 수천 개의 MCP 서버를 Langflow 에이전트에서 도구로 사용 가능

- 단일 인터페이스로 다양한 외부 서비스에 접근

서버로서의 Langflow:

- Langflow의 워크플로우를 MCP 도구로 노출

- 업로드된 파일을 MCP 리소스로 제공

- Claude Desktop 등의 MCP 클라이언트가 Langflow 워크플로우를 활용 가능

Langflow MCP 컴포넌트(출처: Langflow 블로그)

graph TD

subgraph "MCP 에코시스템"

Client1[Claude Desktop] --> |MCP| Langflow

Client2[기타 MCP 클라이언트] --> |MCP| Langflow

Langflow --> |MCP| Server1[외부 MCP 서버]

Langflow --> |MCP| Server2[데이터베이스 MCP 서버]

Langflow --> |MCP| Server3[검색 MCP 서버]

end

style Langflow fill:#ffaa00,stroke:#ff6600

style Client1 fill:#b3e0ff,stroke:#0066cc

style Client2 fill:#b3e0ff,stroke:#0066cc

style Server1 fill:#c6e0b4,stroke:#548235

style Server2 fill:#c6e0b4,stroke:#548235

style Server3 fill:#c6e0b4,stroke:#548235

"Model Context Protocol(MCP)은 Microsoft와 VS Code의 언어 서버(LSP)에서 영감을 받은 Anthropic의 오픈 표준입니다. 대규모 언어 모델(LLM) 애플리케이션과 외부 도구, API 또는 데이터 소스 간의 원활한 상호운용성을 설립하도록 설계되었습니다." - Langflow 블로그

7.3 MCP 도입의 주요 목적

이러한 에이전트 도구들이 MCP를 도입하는 주요 이유는 다음과 같습니다:

- 표준화된 통합: 다양한 외부 시스템과의 연결을 단일 프로토콜로 통합

- 개발 효율성: 각 도구마다 별도의 커스텀 통합 코드 작성 불필요

- 확장성과 유연성: 새로운 도구와 데이터 소스를 쉽게 추가 가능

- 에이전트 역량 강화: AI 에이전트의 기능과 상호작용 능력 향상

- 생태계 호환성: 다양한 AI 도구와 시스템 간의 원활한 통합

7.4 추가 통합 기업들

다양한 기업들이 자사 제품과 MCP의 통합을 제공하고 있습니다:

- Axiom - 로그, 트레이스, 이벤트 데이터 분석

- Cloudflare - Cloudflare 개발자 플랫폼 리소스 관리

- Neon - Neon 서버리스 PostgreSQL 플랫폼 상호작용

- Stripe - Stripe API 상호작용

- Weaviate - Weaviate를 통한 에이전트 RAG 구현

출처: Model Context Protocol 공식 예제 서버

8. 활용 사례 및 장점

8.1 지식 기반 챗봇

MCP 기반 지식 챗봇 구조(출처: Medium)

MCP 기반 지식 챗봇 구조(출처: Medium)

graph TD

User[사용자] --> Chatbot[챗봇 인터페이스]

Chatbot --> MCP[MCP 클라이언트]

MCP --> LLM[LLM API]

MCP <--> Server[MCP 서버]

Server --> DB[지식 데이터베이스]

Server --> Search[검색 엔진]

Server --> RAG[RAG 시스템]

style User fill:#d9d9d9,stroke:#666666

style Chatbot fill:#b3e0ff,stroke:#0066cc

style MCP fill:#b3e0ff,stroke:#0066cc

style LLM fill:#b3e0ff,stroke:#0066cc

style Server fill:#c6e0b4,stroke:#548235

style DB fill:#c6e0b4,stroke:#548235

style Search fill:#c6e0b4,stroke:#548235

style RAG fill:#c6e0b4,stroke:#548235- 회사 내부 문서, FAQ, 지식 베이스를 MCP 리소스로 노출

- 검색, 필터링 기능을 MCP 도구로 제공

- 자연어 쿼리를 SQL, 벡터 검색 등으로 변환하는 도구 구현

- 표준화된 응답 형식을 위한 프롬프트 템플릿 제공

실제 사례: Elastic의 MCP 서버

Elastic은 Elasticsearch를 위한 MCP 서버를 구현하여 LLM이 대규모 데이터에 효율적으로 접근할 수 있도록 했습니다.

"MCP 서버는 LLM과 Elasticsearch 사이의 통신 브리지 역할을 하여, 자연어 질문을 구조화된 쿼리로 변환하고 인덱스에서 관련 데이터를 검색합니다." - Elastic 블로그

8.2 데이터 분석 도우미

graph TD

User[데이터 분석가] --> App[분석 애플리케이션]

App --> MCP[MCP 클라이언트]

MCP --> LLM[LLM API]

MCP <--> Server[MCP 서버]

Server --> DB[데이터베이스]

Server --> Viz[시각화 도구]

Server --> Stats[통계 라이브러리]

style User fill:#d9d9d9,stroke:#666666

style App fill:#b3e0ff,stroke:#0066cc

style MCP fill:#b3e0ff,stroke:#0066cc

style LLM fill:#b3e0ff,stroke:#0066cc

style Server fill:#c6e0b4,stroke:#548235

style DB fill:#c6e0b4,stroke:#548235

style Viz fill:#c6e0b4,stroke:#548235

style Stats fill:#c6e0b4,stroke:#548235- 데이터 조회, 필터링, 집계 기능을 MCP 도구로 제공

- 데이터 시각화 생성 기능을 MCP 도구로 구현

- 통계 분석, 예측 모델링 도구 제공

- 분석 결과 해석 및 보고서 작성을 위한 프롬프트 템플릿

실제 사례: Tinybird MCP 서버

Tinybird는 ClickHouse 기반의 분석 플랫폼을 위한 MCP 서버를 구현해 대규모 데이터셋에 대한 실시간 분석을 가능하게 합니다.

Tinybird MCP 서버 구조(출처: GitHub)

Tinybird MCP 서버 구조(출처: GitHub)

8.3 개발자 도구 통합

graph TD

User[개발자] --> IDE[통합 개발 환경]

IDE --> MCP[MCP 클라이언트]

MCP --> LLM[LLM API]

MCP <--> Server[MCP 서버]

Server --> Git[Git 저장소]

Server --> Docs[API 문서]

Server --> Issue[이슈 트래커]

Server --> Test[테스트 도구]

style User fill:#d9d9d9,stroke:#666666

style IDE fill:#b3e0ff,stroke:#0066cc

style MCP fill:#b3e0ff,stroke:#0066cc

style LLM fill:#b3e0ff,stroke:#0066cc

style Server fill:#c6e0b4,stroke:#548235

style Git fill:#c6e0b4,stroke:#548235

style Docs fill:#c6e0b4,stroke:#548235

style Issue fill:#c6e0b4,stroke:#548235

style Test fill:#c6e0b4,stroke:#548235- 코드베이스, 문서, 이슈 트래커 등을 MCP 리소스로 노출

- 코드 생성, 리팩토링, 버그 수정 도구 제공

- 단위 테스트 생성, 코드 리뷰 자동화 도구 구현

- 코딩 스타일, 문서화 규칙에 맞는 프롬프트 템플릿 제공

실제 사례: Cursor IDE의 MCP 통합

Cursor IDE는 MCP 클라이언트로서 다양한 MCP 서버와 통합되어 AI 코드 지원 기능을 제공합니다.

"Cursor IDE는 MCP를 통해 코드베이스 검색, GitHub 이슈 추적, 문서 생성 등 다양한 개발 작업을 AI로 지원합니다." - Cursor 블로그

8.4 최종 사용자 경험 향상

현재 AI 경험:

사용자: "다음 주 회의 일정을 만들어줘"

AI: "죄송합니다, 저는 귀하의 일정에 접근할 수 없습니다.

다음과 같은 일정 형식을 참고하시겠어요?"MCP를 통한 AI 경험:

사용자: "다음 주 회의 일정을 만들어줘"

AI: "팀원들의 가용 시간을 확인했습니다. 다음 주 화요일 오후 2시에

모든 팀원이 참석 가능합니다. 회의실 A도 예약 가능합니다.

이 시간으로 회의를 예약할까요?"

사용자: "좋아, 예약해줘"

AI: "화요일 오후 2시 회의실 A에 '팀 주간 미팅'으로 예약했습니다.

모든 팀원에게 초대장을 보냈습니다." MCP 기반 사용자 경험(출처: Descope)

MCP 기반 사용자 경험(출처: Descope)

8.5 개발자에게 주는 이점

- 통합 단순화: 한 번의 MCP 구현으로 다양한 AI 애플리케이션과 연동 가능

- 표준화된 인터페이스: 일관된 방식으로 도구와 데이터 접근

- 역할 분리: 클라이언트/서버 개발자가 독립적으로 작업 가능

- 코드 재사용: 공통 컴포넌트 공유 및 재사용 용이

- 생태계 접근성: 표준을 준수하는 다양한 도구와 리소스 활용 가능

"MCP는 개발자에게 매우 중요한 이점을 제공합니다. 통합 비용을 낮추고, 통합 설치 공간을 줄이며, 수정이 필요한 코드의 양을 줄여 유지 관리를 단순화합니다." - AWS Community

8.6 MCP와 LangChain 비교

| 특성 | MCP | LangChain |

|---|---|---|

| 타입 | 프로토콜 | 프레임워크 |

| 목적 | 표준화된 통신 | 애플리케이션 구축 |

| 강점 | 상호운용성 | 풍부한 컴포넌트 |

| 종속성 | 낮음 (벤더 중립적) | 프레임워크에 종속 |

| 통합 방식 | 표준화된 인터페이스 | 프레임워크 API |

| 확장성 | 독립적인 구현체 추가 | 프레임워크 내 확장 |

MCP와 LangChain은 상호 배타적이지 않으며, LangChain도 MCP를 표준으로 채택할 수 있습니다. 실제로 LangChain은 MCP 지원을 추가하여 두 기술의 장점을 결합하고 있습니다.

MCP와 LangChain(출처: Medium)

. MCP 미래 전망

9.1 산업적 영향

기업 생산성 향상

- 워크플로우 자동화: 부서 간 데이터 흐름 개선 및 반복 작업 감소

- 의사결정 지원: 여러 시스템의 데이터를 통합해 더 나은 비즈니스 인사이트 제공

- 지식 관리 향상: 기업 내 정보 접근성 향상으로 지식 공유 촉진

소프트웨어 생태계 변화

- 플랫폼 연결성: 다양한 소프트웨어 간 원활한 통합 가능

- AI 기능 민주화: 작은 앱 개발자도 강력한 AI 기능 쉽게 구현 가능

- 새로운 앱 카테고리: AI 에이전트와 사용자를 연결하는 새로운 유형의 애플리케이션 등장

9.2 도입 타임라인

MCP는 초기 단계지만 유망한 미래를 제시합니다:

- 현재 (2025): 얼리 어답터 기업이 MCP를 실험적으로 도입

- 단기 (1-2년): 표준화 진전 및 주요 앱과 서비스의 MCP 지원 확대

- 중장기 (3-5년): MCP가 AI 애플리케이션 개발의 표준 방식으로 자리잡을 것으로 예상

9.3 비즈니스 측면의 MCP 가치

경영진 관점

- 투자 효율성: 여러 시스템 간 통합을 위한 커스텀 개발 비용 감소

- 혁신 가속화: 새로운 AI 기능을 더 빠르게 도입할 수 있는 기반 제공

- 사용자 경험 향상: 직원과 고객에게 더 스마트한 디지털 경험 제공

10. Q&A

Q: MCP는 기존 API와 어떻게 다른가요?

A: MCP는 특별히 LLM 애플리케이션을 위해 설계되었으며, 리소스, 도구, 프롬프트라는 LLM 중심 개념을 중심으로 구성됩니다. 또한 URI 템플릿, 메시지 구조, 비동기 통신 등 LLM과의 상호작용에 최적화된 기능을 제공합니다.

MCP와 API 비교(출처: Descope)

MCP와 API 비교(출처: Descope)

Q: MCP 서버 구현의 성능은 어떤가요?

A: MCP TypeScript SDK는 효율적인 비동기 처리를 통해 높은 성능을 제공합니다. 또한 필요에 따라 여러 전송 계층을 선택할 수 있어 다양한 환경에서 최적화가 가능합니다. 벤치마크 테스트에 따르면 MCP를 통한 통합은 기존 API 통합 방식에 비해 동등하거나 더 나은 성능을 보여줍니다.

Q: MCP는 어떤 LLM과 함께 사용할 수 있나요?

A: MCP는 LLM에 독립적이며, OpenAI, Anthropic, Google, 오픈소스 LLM 등 모든 LLM 제공자와 함께 사용할 수 있습니다. 현재 Claude를 탑재한 Anthropic의 애플리케이션들이 가장 적극적으로 MCP를 활용하고 있으나, 다른 LLM 제공자들도 점차 MCP 지원을 추가하고 있습니다.

MCP를 지원하는 여러 LLM 클라이언트들(출처: Merge.dev)

MCP를 지원하는 여러 LLM 클라이언트들(출처: Merge.dev)

Q: 대규모 시스템에서 MCP를 확장하는 방법은 무엇인가요?

A: MCP는 모듈식 아키텍처를 채택하고 있어 마이크로서비스 구조에 적합합니다. 다음과 같은 확장 방법을 사용할 수 있습니다:

- 여러 MCP 서버 배포: 각 기능 영역별로 별도의 MCP 서버를 배포

- 로드 밸런싱: MCP 서버 앞에 로드 밸런서를 두어 트래픽 분산

- 수평적 확장: 동일한 MCP 서버의 여러 인스턴스 실행

- 분산 배포: 여러 지역에 MCP 서버를 배포하여 지연 시간 최소화

"MCP는 대규모 분산 시스템에서도 효과적으로 작동합니다. 각 MCP 서버는 독립적으로 작동하면서도 표준화된 인터페이스를 통해 전체 시스템과 통합됩니다." - AWS Community

Q: MCP와 LangChain, LlamaIndex 등의 프레임워크와의 통합은 어떻게 되나요?

A: MCP는 이러한 프레임워크와 함께 사용할 수 있습니다. 이미 LangChain은 MCP 도구 지원을 추가했으며, LlamaIndex도 MCP 통합을 진행 중입니다. 이러한 통합을 통해 프레임워크의 풍부한 기능과 MCP의 표준화된 통신 방식을 함께 활용할 수 있습니다.

LangChain MCP 통합(출처: Medium)

LangChain MCP 통합(출처: Medium)

Q: MCP는 보안 측면에서 어떤 기능을 제공하나요?

A: MCP는 다음과 같은 보안 기능을 제공합니다:

- 전송 계층 보안: TLS를 통한 암호화된 통신

- 인증 메커니즘: Bearer 토큰, API 키 등 다양한 인증 방식 지원

- 권한 관리: 리소스와 도구에 대한 세밀한 접근 제어

- 입력 검증: Zod를 사용한 타입 안전성 및 입력 유효성 검사

- 감사 로깅: 모든 요청과 응답에 대한 추적 가능성

Q: 소규모 회사에서도 MCP를 도입할 만한 가치가 있을까요?

A: 네, 소규모 회사에서도 다음과 같은 이유로 MCP 도입이 가치 있습니다:

- 개발 시간 단축: 표준화된 방식으로 빠르게 AI 기능 구현 가능

- 미래 호환성: AI 생태계의 표준을 채택하여 장기적인 호환성 확보

- 확장성: 비즈니스 성장에 따라 쉽게 확장 가능한a 아키텍처

- 생태계 활용: 이미 존재하는 다양한 MCP 서버와 도구 활용 가능

"소규모 회사일수록 개발 리소스가 제한적이기 때문에, MCP와 같은 표준화된 접근 방식을 통해 개발 시간을 단축하고 기존 생태계의 도구를 활용하는 것이 더 큰 가치를 가질 수 있습니다." - InfraCloud 블로그

Q: 어떤 종류의 애플리케이션이 MCP 도입에 가장 적합한가요?

A: 다음과 같은 애플리케이션이 MCP 도입에 특히 적합합니다:

- AI 챗봇 및 어시스턴트: 다양한 데이터 소스와 도구에 접근이 필요한 대화형 AI

- 지식 관리 시스템: 내부 문서, 데이터베이스 등에 접근하는 AI 기반 시스템

- 개발자 도구: 코드 리포지토리, 이슈 트래커 등과 통합되는 AI 코딩 도우미

- 데이터 분석 플랫폼: 다양한 데이터 소스와 분석 도구를 활용하는 AI 기반 분석 시스템

- 업무 자동화 도구: 여러 시스템과 서비스를 오케스트레이션하는 AI 워크플로우

참고 자료

- Model Context Protocol 공식 문서: https://modelcontextprotocol.io/

- MCP TypeScript SDK: https://github.com/modelcontextprotocol/typescript-sdk

- MCP 사양 문서: https://spec.modelcontextprotocol.io/

- MCP 예제 서버: https://github.com/modelcontextprotocol/servers

- MCP 인스펙터(테스트 도구): https://github.com/modelcontextprotocol/inspector

'AI' 카테고리의 다른 글

| MCP TypeScript SDK 종합 분석 (0) | 2025.04.13 |

|---|---|

| MCP(Model Context Protocol) 서버 개발 가이드: LLM과 외부 도구의 완벽한 통합 (0) | 2025.04.11 |

| MCP(Model Context Protocol) 클라이언트 개발 가이드: LLM과 외부 도구 통합하기 (0) | 2025.04.11 |

| MCP(Model Context Protocol)의 보안 위험과 방지책 (0) | 2025.04.09 |

| MCP란? (0) | 2025.04.09 |